Se potessimo salvare alcuni papiri della biblioteca di Alessandria quale documento sceglieremmo e in base a quali criteri opereremmo le nostre scelte?

.

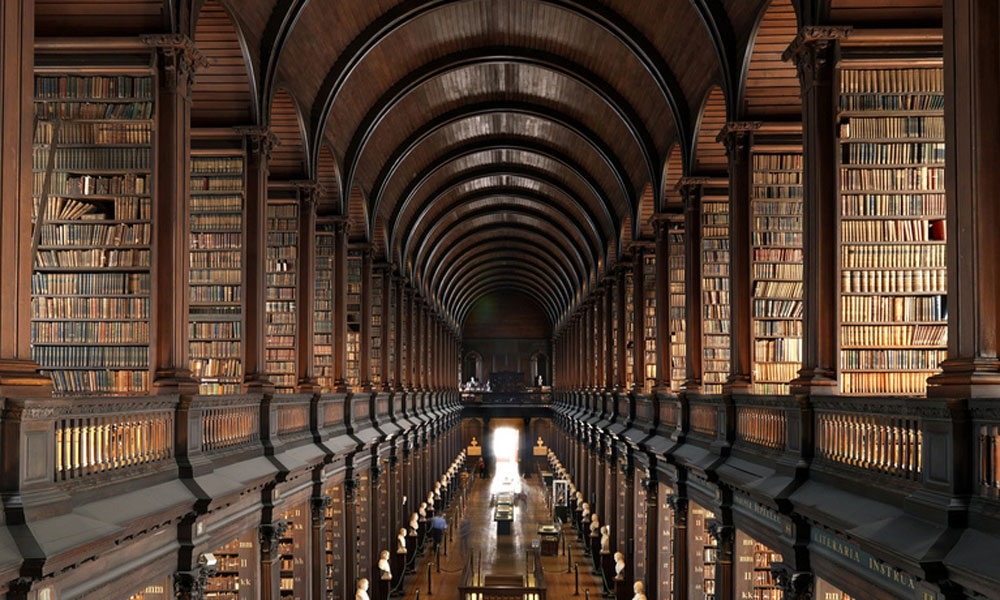

Questo mese esce un articolo molto interessante su Science [1]. Gli autori [2] pongono una fondamentale domanda filosofica sulla conoscenza scientifica e sviluppano una analisi statistica per cercare la risposta. Immaginiamoci di trovarci nella biblioteca di Alessandria di Egitto prima del famoso rogo che distrusse ampia parte della documentazione scientifica, filosofica e religiosa del tempo. Se potessimo salvare alcuni di questi papiri quale documento sceglieremmo e in base a quali criteri opereremmo le nostre scelte? Questa domanda e’ di grande attualita’, proprio perche’ la nostra societa’ tende a pensare che tutto quello che sia moderno sia preferibile al sapere antico. Ma non e’ sempre stato cosi’, ci sono stati periodi storici in cui la conoscenza dei classici era considerata superiore rispetto alla conoscenza attuale. In generale entrambe le strategie di ricerca, documentazione corrente e aggiornata, piuttosto che antica e consolidata, hanno un fondamento logico, famosi sostenitori e detrattori. Ma a questa domanda gli autori cercano una risposta analitica, statistica, indipendente dalle scuole di pensiero.

Si tratta di una ricerca quantitativa su ventotto milioni di articoli scientifici e cinque milioni di brevetti, quindi uno studio importante con un obiettivo ambizioso, la ricerca di una relazione quasi-universale tra conoscenza e innovazione. Cerchiamo quindi di esaminare il testo, le illustrazioni, il metodo e di verificare insieme se l’esposizione e l’interpretazione dei risultati e’ coerente con la domanda iniziale.

Nello studio vengono analizzate le date dei riferimenti bibliografici dei milioni di pubblicazioni contenuti nelle banche dati elettroniche delle principali associazioni scientifiche. Per ciascuna pubblicazione viene calcolata la distribuzione della eta’ delle fonti citate e da questa distribuzione viene calcolata la media e il coefficiente di variazione. Queste due grandezze, riportate nei grafici nella notazione Dμ e Dθ rispettivamente, sono scelti come indicatori sintetici dell’eta’ della conoscenza scientifica.

Come metrica di valutazione della rilevanza dell’innovazione viene utilizzato il numero di citazioni nei primi otto anni successivi alla pubblicazione. Parliamo quindi del fattore di impatto, una metrica che e’ stata piu’ volte dibattuta e criticata. Il fattore di impatto dipende infatti dal numero medio di riferimenti bibliografici per campo scientifico, che non viene riportato nella ricerca. I dati dei database internazionali [3] mostrano infatti che le citazioni in campo medico-biochimico arrivano a circa 30 citazioni per articolo mentre in campo matematico-ingegneristico sono intorno a 10 citazioni per articolo. Tanto piu’ ricca la bibliografia media tanto piu’ alto il numero di citazioni. Il fattore di impatto e’ calcolato per campo scientifico. Nello studio infatti questa metrica viene normalizzata, per cui viene assegnato un fattore 1 alle pubblicazioni che hanno alto fattore di impatto, precisamente nel primo 5%, e un fattore 0 alle altre meno rilevanti. Successivamente vengono applicate altre metriche, con diverse soglie (1% 10% 25%) per verificare la robustezza della prima approssimazione. Non abbiamo avuto modo di consultare il materiale supplementare relativo a queste metriche, che secondo gli autori mostrerebbe risultati analoghi [4].

Lo studio mette in relazione la rilevanza dell’innovazione alle due metriche che rappresentano l’eta’ della conoscenza, evidenziando un “hot spot”, una zona caratteristica dove sono localizzabili le pubblicazioni a maggiore impatto scientifico. Sono le pubblicazioni che hanno una eta’ bassa e una varianza media , quindi le pubblicazioni con una bibliografia recente ma che danno anche spazio a vecchie pubblicazioni, secondo gli autori [5- fig 1]. I risultati sono in linea con la nostra esperienza di lettori di documentazione scientifica. Tipicamente nella bibliografia di ogni articolo scientifico o un brevetto troviamo citate le ultime pubblicazioni sull’oggetto della ricerca e alcune pubblicazioni fondamentali che sono all’origine del filone di ricerca.

Un’attenta analisi dei risultati quantitativi mostra tuttavia una realta’ diversa da quella raccontata su Science. Abbiamo provato a ricostruire le distribuzioni di questo “hot spot”. Partendo dai dati della media e del coefficiente di variazione, abbiamo costruito distribuzioni ipotetiche che rientrano nella zona designata. Purtroppo lo studio non riporta un parametro importante per distribuzioni con piccoli numeri, il numero di riferimenti bibliografici per pubblicazione. Con un trattazione algebrica possiamo tuttavia superare questo ostacolo.

Partiamo dalla identificazione della zona “hot spot”, compresa nel seguenti range numerico Dμ,=2-6 e Dθ=0.7-2.0. Il parametro dell’eta’ media non necessita’ di grandi argomentazioni e indica che solo le pubblicazioni con riferimenti bibliografici recenti riescono a posizionarsi nella zona a maggior impatto scientifico. Di seguito indicherò con l’aggettivo recente tutte le pubblicazioni con una data inferiore a 10 anni. Possiamo costruire diverse distribuzioni con N riferimenti bibliografici di eta’ compresa tra una data minima D1 e massima DN. Ipotizziamo quindi una bibliografia di N-1 riferimenti recenti con un unico riferimento ad un riferimento bibilografico storico. Di seguito indichiamo un riferimento storico come un riferimento con eta’ uguale o superiore ai 10 anni.

Questa citazione dal punto di vista statistico e’ un “outlier”, per cui riprendendo la notazione degli autori, la definiamo Do. Cerchiamo di definire quanto vecchia puo’ essere questa citazione per soddisfare i criteri di “hot spot”. Il contributo alla media della citazione storica e’ dato dalla formula DeltaDμ=(Do-Dμ)/N, per cui gia’ un articolo di 30 anni su una bibliografia di 10 citazioni sposterebbe la media fuori dallo “hot spot”. Nel caso di una bibliografia piu’ ricca, ad esempio di 20 riferimenti, ci sarebbe spazio per due articoli storici. Similmente possiamo calcolare di quanto si sposterebbe il coefficiente di variazione per un articolo storico, mediante la seguente formula DeltaDθ=sqrt(Dθ^2+(Do-Dμ)) /(Do-Dμ) . Per Do>>Dμ la formula può’ essere approssimata come segue DeltaDθ=sqrt(Dθ^2+Do^2) /Do e per e Do>>Dθ il fattore di correzione risulta Delta Dθ=1. Il range del coefficiente di variabilità’ e’ relavitamente ampio, Dθ=0.7-2.0, tuttavia un solo riferimento storico sposta notevolmente la distribuzione originaria nella nuova zona Dθ=1.7-3.0 che e’ quasi interamente fuori dall’”hot spot”.

Come abbiamo già’ accennato, un riferimento al caposcuola e’ tipico della modalità’ di redazione di una bibliografia moderna. L’analisi quantitativa ci indica tuttavia che questi riferimenti a pubblicazioni storiche sembrano essere puramente formali, una specie di rito o passaggio obbligato per indicare di non aver dimenticato la citazione di Newton che costruiamo la nostra scelta sulle spalle dei giganti. Un analisi completa delle distribuzioni possibili mostra casistiche fino a 2 riferimenti storici su distribuzioni di articoli molto recenti.

Lo studio a questo punto propone una dubbia sostituzione, sostituendo al concetto di “hot spot” il concetto di “hot quadrant”, il quadrante dove si trovano le pubblicazioni con bassa eta’ e alto coefficiente di variazione [5- fig 2]. Logicamente non tutte le pubblicazioni in questo quadrante corrispondo all’ “hot spot”. La distribuzione delle pubblicazioni in questo quadrante principale include anche quelle pubblicazioni con una lunga coda di riferimenti storici con riferimenti ad articoli molto vecchi, che tuttavia sono fuori dalla zona di alto impatto scientifico.

Purtroppo l’affasciante domanda filosofica iniziale trova una risposta negativa nei risultati presentati. Si delinea una strategia efficace per la comunità’ scientifica nel pubblicare con riferimenti a letteratura prevalentemente moderna. Di fatto constatiamo che gli scienziati che utilizzano un metodo di citazione ”hot spot” hanno maggiore probabilità’ di essere a loro volta citati dal sistema “hot spot”. Questo e’ tipico di un “network” e come in ogni sistema neurale il sistema converge verso l’ottimo rispetto alla metrica definita. Se la metrica e’ il fattore di impatto il sistema si allinea per ottimizzare i parametri che portano a massimizzare il numero di citazioni in ambito scientifico.

Il trend storico riportato nell’articolo mostra inoltre che negli ultimi 50 anni e’ diminuita ulteriormente l’eta’ dei riferimenti bibliografici [5- fig 3] e sono aumentati i campi scientifici che rispondono a questi criteri [5- fig 4].

Secondo la nostra interpretazione questo modo di fare pubblicazioni crea un taglio netto nei confronti del passato, per cui alcune scuole di pensiero rischiano di venire abbandonate e perdute. Tutto questo riporta al rischio di una crescente omologazione del pensiero scientifico.

Dobbiamo riportare, per dovere scientifico, che già in un articolo degli anni sessanta [6] veniva riconosciuto il problema dell’ “immediacy factor” ovvero della pratica di massimizzare il numero di citazioni prediligendo riferimenti a pubblicazioni recenti, con il rischio che il resto della pubblicazione scientifica diventi obsolescente.

Un fatto curioso e’ che nessuna delle pubblicazioni di Einstein non sarebbe caduta nell’ “hot spot” . Sappiamo ad esempio che le pubblicazioni di Einstein erano state criticate a suo tempo per avere una bibliografia incompleta.

Altro fatto interessante, nessuna della moderna ricerca nella elettrodinamica, condotte da autorevoli università’ internazionali sarebbe degna di essere in questo “hot spot”, in quanto presentano riferimenti bibliografici piu’ vecchi di 100 anni fa.

RIFERIMENTI

[1] http://advances.sciencemag.org/content/3/4/e1601315

[2a] https://scholar.google.com/citations?user=uGJ_6aQAAAAJ

[2b] https://scholar.google.com/citations?user=uzkrkCUAAAAJ

[2c] https://scholar.google.com/citations?user=c4M3MQoAAAAJ

[2d] https://scholar.google.de/citations?user=DpXNJUQAAAAJ&hl=en

[4] http://advances.sciencemag.org/content/suppl/2017/04/17/3.4.e1601315.DC1

[5] http://advances.sciencemag.org/content/3/4/e1601315/tab-figures-data

[6] http://garfield.library.upenn.edu/papers/pricenetworks1965.pdf

.

.

.

11 commenti

Interpretazione correttissima la Sua, ing. Marchi, della metanalisi di Science. Completa, mi pare, le ricerche di Ioannidis sulla preponderanza di articoli falsi nella letteratura scientifica! Non mi ero mai immaginato di quantificare la situazione, ma l’impressione derivante dalla sempre maggiore difficoltà di trovare un’applicabilità, un’idea su cui investire, nel sempre più grande blob dei paper mi aveva portato alle stesse conclusioni.

Come uscire dalla parafrasi e dall’autoreferenzialità?

La cosa più’ curiosa, che non ho volutamente riportato nell’articolo, e’ che uno dei principali autori dello studio ha 20.000 citazioni in ambito scientifico. Quindi parliamo di un illustre accademico che ha appreso molto bene l’arte della pubblicazione efficace. Quanto alla correttezza formale e sostanziale della pubblicazione in oggetto, sappiamo che non e’ interesse dei revisori portare argomentazioni significative durante la revisione. Il primo problema del processo di correzione delle pubblicazione scientifiche e’ che non e’ remunerato economicamente. Il secondo e’ che e’ anonimo, quindi non ha rilevanza in termini di crediti scientifici. Le cattedre degli accademici sono pieni di papers che devono essere letti e riveduti, frettolosamente, ma senza un impegno sostanziale. La revisione, interpretazione e correzione delle ricerche scientifiche dovrebbe invece essere invece al centro della ricerca. La realtà’ e’ invece diversa e sappiamo che normalmente ai convegni la relazione risulta noiosa e la discussione dopo la presentazione inesistente; il moderatore si sforza di fare una domanda per far capire di avere capito, e li finisce il tutto. Alla base della deriva della ricerca accademica, c’e’ la convinzione che idee e modelli abbiano valore intrinseco. Come si dice nel business, le idee valgono poco, mentre la applicazione, che porta a interpretazione, discussione e ulteriori sviluppi e’ il vero cardine del progresso scientifico e tecnologico.

Eh, già, ing. Marchi. Da giovane avevo un’adorazione per i fisici, teorici in particolare, motivo per cui mi sono iscritto a fisica; e aborrivo gli ingegneri, trovando “banale” la loro attività di semplice applicazione e di pignolo calcolo. Ma ora, con gran parte della fisica fuggita per la tangente della fantasia hollywoodiana – alieni, multiversi, viaggi nel tempo, Matrix, ecc., ecc. – la scienza sarà salvata dai piedi per terra degli ingegneri?

Lo spettacolo deve andare avanti su tutti gli schermi. Non è una questione di ingegneria o fisica. Anche nelle grandi aziende c’è molto spettacolo. Però le nuove richieste del mercato sono precise e definite: conoscenza, matematica e programmazione. Fuori dal campo dello spettacolo si sta delineando un chiaro bisogno di costruire modelli applicativi che rispondano ai sistemi complessi. Io credo che la fase dell’idealismo nella fisica e nel progresso tecnologici stia giungendo al termine. Come dice Jeremy Eden abbiamo colto i frutti facili da raggiungere dai nostri alberi. Gli altri frutti sono molto più in alto. Probabilmente avremo bisogno di nuove discipline, non solo fisica e ingegneria.

Aerticolo molto interessante. Già qui su CS era apparsa qualche mia nota diciamo critica, se non negativa, sui criteri con cui vengono istituiti ed adoperati gli indici delle “peer review” per giustificare in senso autoreferinziale – almeno potenzialmente – qualsiasi posizione ipotetica, giungendo a trasformarla in assodata, quasi per magia. Mi sembra dunque che questo nuovo aspetto, ben indicato dall’ing. Marchi nel suo prezioso contributo, vada a completare un quadro sostanzialmente a tinte fosche. Concludo ricordando un paio di nozioni che a me sembrano convergenti con questo scenario e che riguardano le critiche che sono state rivolte all’impact factor (in primis quella del matematico Alessandro Figà Talamanca, nel suo storico discorso dal titolo “L’Impact Factor nella valutazione della ricerca e nello sviluppo dell’editoria scientifica” al convegno SINM del 2000) e sul “demenziale” (sic!) h-index, del compianto Giorgio Israel (http://gisrael.blogspot.it/2011/07/ancora-sul-demenziale-h-index.html) Per inciso, alla domanda iniziale, risponderei ovviamente in questo modo: sarebbero da salvare prima di tutto i testi meno conosciuti. Quali che essi siano. Le voci discordanti, che oggi vengono dalla letteratura indipendente, sono sempre le più preziose. Per un logico motivo: la dialettica – quella positiva – si nutre di opposti, altrimenti non si dà alcun superamento, nessuna crescita, nessun progresso.

Criterio interessante: i meno noti. Quelli che hanno meno probabilità di essere letti.

La misura dell’informazione è il logaritmo dell’inverso della probabilità…

È questa la formulazione matematica della mia tesi? Suona bene.

Un processo stocastico additivo da’ luogo ad una distribuzione normale, mentre un processo moltiplicativo da’ luogo ad una distribuzione lognormale. Per questo motivo i processi complessi portano a distribuzioni con code lunghe. Insomma, la conoscenza non sta nel medio e neppure nella mediana, ma viene caratterizzata da tutte le sue code divergenti, che non possono essere ne smussate ne’ tagliate.

Come amo ripetere con i miei colleghi di Dipartimento, “impact factor” o “h-index” non sono nient’altro che la versione cervellotica del disneyano specchio di Grimilde…

🙂

Il caro vecchio Albert sarebbe sarebbe rimasto fuori dalle “Hot Spot” ! Questo spiega più di ogni altra cosa quale sia l’ efficacia dei dati quantitativi nella capacità di intercettare la qualità.

Aiuta a spiegare anche come, in un’ epoca di diffusissima alfabetizzazione, quindi di massima capacità di cumulare e diffondere informazione, questa abbia assunto in modo sorprendente connotati di sciatteria, mediocrità e conformismo con modalità che, a volte, che sfiorano il ridicolo.

La neolingua del “politicamente corretto” è un esempio da studiare con attenzione.